突破Pick&Place,實現(xiàn)長程任務泛化!首個端到端強化學習具身模型Psi R0,橫空出世

近日,靈初智能發(fā)布首個基于強化學習(RL)的端到端具身模型Psi R0。該模型支持雙靈巧手協(xié)同進行復雜操作,將多個技能串聯(lián)混訓,生成具有推理能力的智能體,從而完成并閉環(huán)長程靈巧操作任務。并且,Psi R0還可以實現(xiàn)跨物品、跨場景級別的泛化。

真實世界中,人類生活近乎100%的場景涉及抓握、轉動、捏取、觸摸等操作,而其中超過 90% 的操作屬于多技能融合的長程任務。然而在當下具身業(yè)界,多局限于Pick and Place操作的泛化,一旦任務復雜化、長程化,泛化性和成功率則大大降低,無法兼顧——這也是具身智能只能存在于demo,遲遲無法在真實場景中落地的核心原因!機器人如何突破Pick and Place、脫離遙操作,擁有自主完成長程靈巧操作的能力,實現(xiàn)真正類人的場景級任務閉環(huán),仍是具身智能亟待攻克的難題。

RL是長程靈巧操作實現(xiàn)任務閉環(huán)的唯一解

在真實世界中,機器人解決長程任務必須通過Learning-based模式,目前主流技術路徑有兩種:模仿學習(IL)和強化學習(RL)。

純模仿學習的泛化能力受限于示范行為的多樣性和質(zhì)量。加之長程任務步驟較多,更容易出現(xiàn)分布漂移問題,使得 IL實現(xiàn)長程任務的泛化性能較差,魯棒性也較弱。

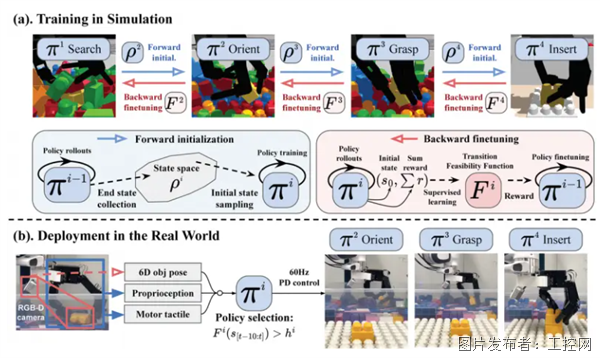

基于RL的Psi R0 模型,使用海量仿真數(shù)據(jù)高效訓練出雙手操作的智能體,并通過雙向訓練框架串聯(lián)多技能,在業(yè)界率先完成開放環(huán)境中的長程任務,具備較強的泛化能力與較高的魯棒性。這一技能訓練框架從物體時空軌跡抽象出關鍵信息以構建通用目標函數(shù),從而解決獎勵函數(shù)難設計的問題。在后訓練階段,通過少量高質(zhì)量真機數(shù)據(jù)對齊,進一步提升長程任務的成功率。除此之外,雙向訓練框架中的轉移可行性函數(shù)發(fā)揮著重要作用,它能夠微調(diào)技能以提高串聯(lián)的成功率與泛化性,同時賦予模型自主切換技能的能力,使其在遭遇操作失敗時能夠迅速調(diào)整策略,確保高成功率。

真實世界中,人類生活近乎100%的場景涉及抓握、轉動、捏取、觸摸等操作,而其中超過 90% 的操作屬于多技能融合的長程任務。然而在當下具身業(yè)界,多局限于Pick and Place操作的泛化,一旦任務復雜化、長程化,泛化性和成功率則大大降低,無法兼顧——這也是具身智能只能存在于demo,遲遲無法在真實場景中落地的核心原因!機器人如何突破Pick and Place、脫離遙操作,擁有自主完成長程靈巧操作的能力,實現(xiàn)真正類人的場景級任務閉環(huán),仍是具身智能亟待攻克的難題。

RL是長程靈巧操作實現(xiàn)任務閉環(huán)的唯一解

在真實世界中,機器人解決長程任務必須通過Learning-based模式,目前主流技術路徑有兩種:模仿學習(IL)和強化學習(RL)。

純模仿學習的泛化能力受限于示范行為的多樣性和質(zhì)量。加之長程任務步驟較多,更容易出現(xiàn)分布漂移問題,使得 IL實現(xiàn)長程任務的泛化性能較差,魯棒性也較弱。

基于RL的Psi R0 模型,使用海量仿真數(shù)據(jù)高效訓練出雙手操作的智能體,并通過雙向訓練框架串聯(lián)多技能,在業(yè)界率先完成開放環(huán)境中的長程任務,具備較強的泛化能力與較高的魯棒性。這一技能訓練框架從物體時空軌跡抽象出關鍵信息以構建通用目標函數(shù),從而解決獎勵函數(shù)難設計的問題。在后訓練階段,通過少量高質(zhì)量真機數(shù)據(jù)對齊,進一步提升長程任務的成功率。除此之外,雙向訓練框架中的轉移可行性函數(shù)發(fā)揮著重要作用,它能夠微調(diào)技能以提高串聯(lián)的成功率與泛化性,同時賦予模型自主切換技能的能力,使其在遭遇操作失敗時能夠迅速調(diào)整策略,確保高成功率。

掃碼環(huán)節(jié)更是考驗機器人的靈巧操作水平,需要雙手高度精細地協(xié)調(diào)彼此相對位置,以確保掃碼槍與商品條碼能夠精準對齊,任何細微偏差都可能導致掃碼失敗。此時,RL訓練策略為雙手雙臂構成的高自由度復雜系統(tǒng)提供了可靠的實時閉環(huán)控制,保障掃碼動作精準流暢地完成。

打包環(huán)節(jié),需要雙手協(xié)調(diào)完成對塑料袋的靈巧操作。在動態(tài)打包的過程中,塑料袋的形狀會隨動作變化,需要實時調(diào)整操作。為了提升機器人對柔性物體的操作適應能力,Psi R0在仿真環(huán)境中模擬多種柔性物體的操作場景,同時結合真機數(shù)據(jù)進行微調(diào)優(yōu)化。甚至在被打斷、干擾的情況下,也能自適應調(diào)整策略,重新進行打包動作。

靈初智能Psi R0模型是具身智能遞歸性成長的第一步。具身智能將遵從從簡單到復雜、從保護到協(xié)同的漸進式演進。在早期,小腦是與真實世界交互的物理基礎,其設計需結合領域知識,滿足環(huán)境中的約束條件,同時具備容錯性,支持大腦學習與優(yōu)化。Psi R0模型發(fā)揮RL算法探索的優(yōu)勢,支持小腦的快速迭代,生成支持長程靈巧操作的智能體。通過靈巧操作轉動數(shù)據(jù)飛輪,實現(xiàn)從小腦Action到大腦Cognition的閉環(huán)回饋,驅動大腦認知能力優(yōu)化,模型持續(xù)迭代,形成小腦協(xié)同+大腦優(yōu)化的具身智能“神經(jīng)回路”,使端到端模型完成從簡單到復雜、從保護到協(xié)同的漸進式演進。返回搜狐,查看更多

提交

龍芯攜手中冶南方發(fā)布GIC通用智能控制器,共筑工業(yè)智控新生態(tài)

福祿克聲學新品震撼上市

AI智啟生活 第15屆深圳國際移動電子展亮點“劇透”

電裝與NTT DATA聯(lián)合解讀SDV時代:智能汽車如何重塑未來出行?

GRAEFF(格拉夫)2025 CHINAPLAS 國際橡塑展邀請函

投訴建議

投訴建議