RK3588實現Deepseek-R1 1.5B模型本地部署,Token實測10.22/s!

1. 前言

DeepSeek-R1的免費開源使得AI模型需求爆增,各大云平臺都在積極接入Deepseek-R1,亞馬遜Amazon和微軟Azure甚至在Deepseek-R1開源后的一周內實現接入,目前國內已有幾百家平臺部署或接入Deepseek。

維準電子基于瑞芯微RK3588國產化平臺對DeepSeek-R1 1.5B的蒸餾模型進行了適配和部署,采用RKLLM Tookit工具實現了NPU平臺對語言模型的加速與量化,為能源電力、智能制造、智慧醫療、AI邊緣計算等工業應用賦能。

作為英偉達官方認可的國產大模型,DeepSeek-R1 以零復雜提示技術降低使用門檻,用戶僅需明確任務目標即可獲得專業級文本生成與語義理解服務,同時其 API 價格僅為行業標桿的 1/10,推動 AI 普惠化。目前,三大運營商已全面接入該模型,結合專屬算力方案,賦能金融、通信、教育等多領域智能化升級。盡管專注于文本領域,其開源生態與高效推理能力仍被國際視為AI 競爭的新標桿,彰顯國家在大語言模型賽道的技術突破。

2. Deepseek-R1模型簡介

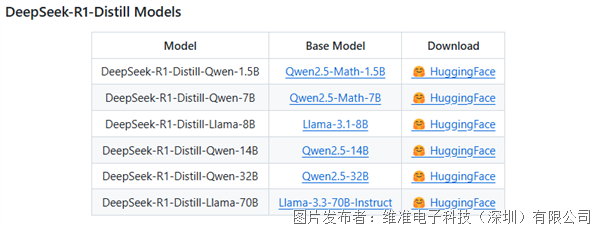

DeepSeek-R1 是由深度求索(DeepSeek)推出的開源大語言模型,以強化學習驅動的高效推理能力為核心,重新定義復雜任務處理范式。通過獨創的 GRPO 強化學習算法實現自我優化,無需依賴監督數據即可在數學推理、代碼生成及邏輯解謎等場景中展現卓越性能。模型支持高精度復雜推理,蒸餾版(R1-Distill)基于 Qwen 和 LLaMA 微調,兼顧輕量化與低成本部署,適配多樣化算力需求。

DeepSeek-R1-Distll-Qwen-1.5B和7B模型通過多階段知識蒸餾技術,將千億級大模型的復雜推理能力壓縮至輕量級架構,實現高性能與低成本的完美平衡。其核心技術包括:

1. 分層蒸餾策略

· 邏輯蒸餾:從教師模型中提取數學推理、代碼生成的邏輯鏈,通過對比學習強化學生模型的思維鏈生成能力;

· 語義蒸餾:基于 KL 散度對齊師生模型的語義空間,保留對長文本、多義詞的精準理解。

2. 動態量化自適應

· 采用混合精度(FP16/INT8)動態量化,在推理時根據任務復雜度自動切換計算模式。

· 通過蒸餾感知量化技術,緩解傳統量化導致的精度損失,數學解題準確率保持教師模型的90%左右。

GitHub官方蒸餾模型評估情況:

3. Deepseek-R1模型部署方案

RK3588為4核Cortex-A76@2.4GHz + 4核Cortex-A55@1.8GHz + 6TOPS算力NPU處理器,它們在能源電力、工業控制、瑕疵檢測、物體識別、智慧醫療等領域有著廣泛應用。

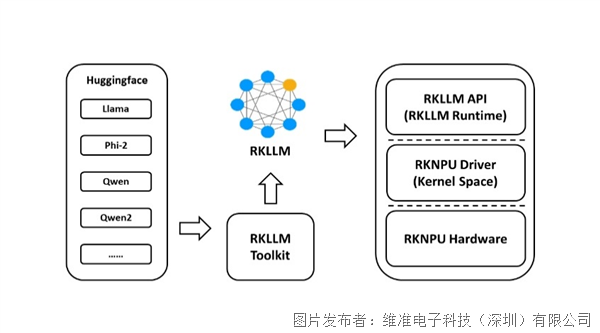

RKLLM-Toolkit是瑞芯微(Rockchip)推出的 AI 模型轉換工具鏈,專為端側設備優化設計,支持將主流大語言模型(如 LLaMA、DeepSeek-R1)高效遷移至 RK3588/RK3576 等芯片平臺。

其核心技術包括:

· 跨框架量化壓縮:支持 PyTorch/TensorFlow 模型轉換為 INT8/INT4 量化格式,進行模型體積壓縮,推理速度顯著提升;

· 異構計算優化:RKNPU專為神經網絡結構設計,自動拆分模型至 NPU+CPU 多核協同計算,動態調度算力資源,能效比提升;

RKLLM-Runtime 負責模型推理,將從RKLLM-Toolkit轉換得到的.rkllm模型在RK3588本地通過調用NPU驅動,加速并進行模型的推理。

目前有兩種DeepSeek-R1部署方案,分別是“RKLLM量化部署”和“Ollama部署”。

由于Ollama部署相比于RKLLM部署性能較弱,只能使用到CPU算力,芯片利用率較低,為了將RK3588強悍的NPU性能發揮出來,推薦使用“RKLLM量化部署”方案。

RKLLM量化部署:使用瑞芯微官方的RKLLM Toolkit工具進行量化部署,模型運行于NPU,適用于RK3588等帶有NPU處理器的平臺。

Ollama工具部署:Ollama是一個開源的大模型服務工具,使用CPU運行,適用于不帶有NPU的通用處理器平臺。

4. RKLLM模型部署

RKLLM軟體架構

RKLLM部署流程

(1) 環境準備

操作系統:確保RK3588開發板運行的是支持ARM64架構的Linux系統(如Ubuntu或Debian)。

依賴工具:安裝必要的工具鏈和依賴庫,例如Python、Git、CMake等。

硬件要求:RK3588開發板需具備足夠的計算資源(CPU、GPU/NPU)和內存(建議至少4GB RAM)。

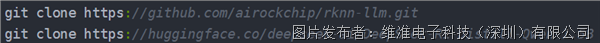

(2) 獲取蒸餾模型Deepseek-R1-Distill-1.5B

下載rknn-llm 和 deepseek模型

(3) RKLLM Toolkit/Runtime工具安裝

在 RKLLM-Toolkit Conda 環境下使用 pip 工具直接安裝所提供的工具鏈 whl 包,在安裝過程中,安裝工具會自動下載 RKLLM-Toolkit 工具所需要的相關依賴包。

#pip3 install rkllm_toolkit-1.1.4-cp38-cp38-linux_x86_64.whl

(4) 編寫.py轉換腳本進行模型轉換

修改export_rkllm.py文件中的模型的存放路徑和NPU核心數量,再執行如下命令運行export_rkllm.py文件將模型導出,使用RKLLM-Toolkit工具將Hugging Face模型轉換為適配瑞芯微NPU的.rkllm格式。

#python export_rkllm.py

(5) 程序交叉編譯

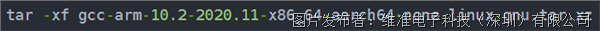

下載編譯工具并解壓縮

編譯工具下載鏈接:https://developer.arm.com/downloads/-/gnu-a

修改編譯腳本指定交叉編譯工具的存放路徑

執行build-linux.sh進行編譯

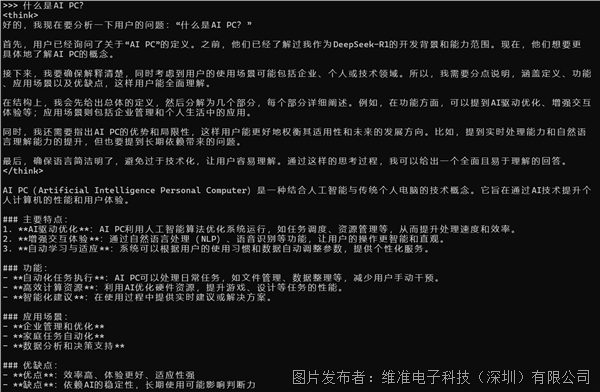

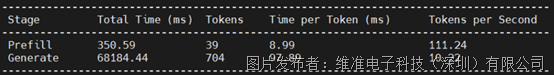

(6)運行展示

RKLLM推理性能:Token 10.22/s

提交

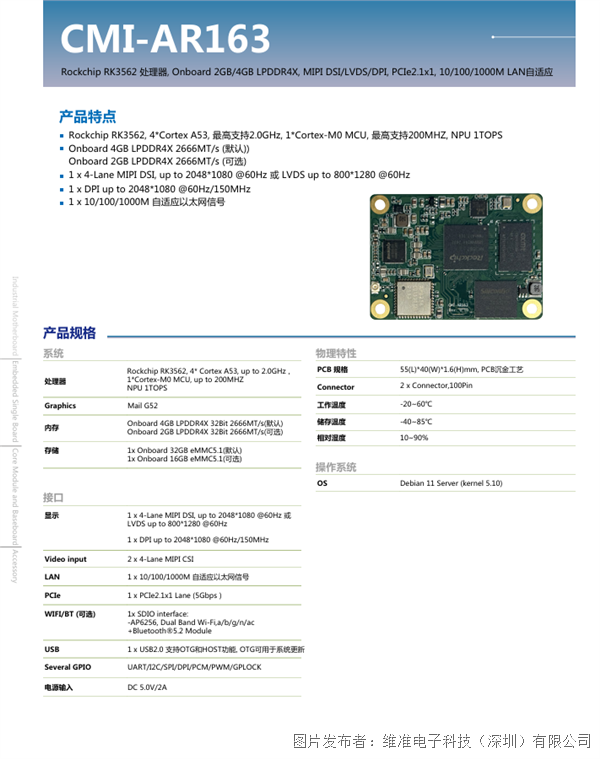

嵌入式板卡CMI-AR163:RK3562核心板兼容樹莓派CM4接口

APLEX維準電子新平臺機器視覺系統AVS-351

維準電子新一代堅固型HMI ARCHMI-S-8B系列

維準電子AVS-201 AI邊緣計算控制器

突破傳統:ARiio-7200的多場景應用彰顯工業級性能

投訴建議

投訴建議